WeShare Novembre 2019

Le WeShare c’est notre rendez-vous de partage de connaissances qui a lieu une fois par mois. C’est l’occasion de passer du temps ensemble, d’échanger sur les sujets qui nous animent. Nous en profitons pour découvrir des outils, des retours d’expériences, mettre un peu les mains dans le code, bref, améliorer nos pratiques et monter en compétences.

Sommaire

Chaque mois, le programme s’articule autour de différents créneaux, allant de présentations théoriques au hands-on en ajoutant un soupçon de communication interne.

Voici un court résumé du WeShare de novembre 2019 :

Présentation de K3S

Jérôme et Romain se sont attaqués à K3S, un Kubernetes allégé fourni par Rancher, dédié à des usages de production sur des cas d’usages appropriés comme de la CI/CD ou des appliances IOT.

On a également pu voir qu’il pouvait très bien faire l’usage d’un environnement de développement simple à mettre en place pour rentrer dans le monde de Kubernetes.

Un présentation globale du produit a été faite, puis une démo de la mise en fonctionnement de l’outil sur une base AWS, Ansible, Terraform, accompagné d’un code open-source mis à disposition.

S’en est suivie une discussion sur les usages potentiels de cette technologie.Cette présentation sera complétée et articulée avec Drone.io lors du WeSpeakCloud du 26 novembre prochain, il est reste encore quelques places gratuites pour cette session ;) !

Mesosphere planet

Nous avons ensuite eu le plaisir de recevoir Denis Jannot et Sofyen Marzougui de D2IQ (anciennement Mesosphere) qui nous ont proposé un tour d’horizon des produits et outils proposés par l’éditeur.

Denis nous a présenté Mesosphere DCOS qui est une plateforme permettant de simplifier et d'automatiser le déploiement et le maintien en condition opérationnelle de tous les services de données (Kafka, Spark, Cassandra, Elastic, Hadoop, MongoDB, TensorFlow, NiFi, Prometheus, Jupyter, etc.), d'intégration continue (Jenkins, Gitlab, JFrog, Spinnaker, etc.) dont les développeurs (Devs) et les administrateurs systèmes (Ops) ont besoin pour développer et déployer des applications modernes ou pour mettre en place une plateforme de Data Science à travers différents clouds, privés et/ou publics. Cette solution permet également d'automatiser le déploiement et la gestion du cycle de vie de plusieurs clusters Kubernetes (ajout de noeuds, mises à jour sans interruption de service, etc.) tout en optimisant les coûts associés.

Dans un second temps, Denis nous a présenté le nouvel outil KONVOY qui est une distribution Kubernetes pour les applications Cloud-natives. Konvoy permet de simplifier, d'automatiser et d'industrialiser le déploiement des clusters Kubernetes et de leur écosystème.

Présentation d’un nouveau venu

Akram Riahi, qui nous a fait le plaisir de nous rejoindre en Septembre dernier, a pris quelques minutes pour se présenter. Nous sommes heureux de te compter parmi nous. Akram est un passionné de technologies et plus particulièrement par Kubernetes et l’ensemble des pratiques du Chaos Engineering. Vous pouvez d’ailleurs lire ou relire son article : Le guide de Chaos Engineering : Partie 1.

Bienvenue chez WeScale Akram !

HandsOn Sécurité et optimisation des comptes Cloud

Un des moments forts de la journée fût l’organisation d’un atelier “Sécurité et optimisation des infrastructures AWS et GCP”. L’objectif de ce hands-on était de développer en binômes des outils permettant d’automatiser la remédiation et l’alerting en appliquant des contraintes de sécurité afin d’améliorer la gestion des infrastructures. Notre objectif est de bloquer les usages hors normes et d’être alertés au plus vite en cas de problème pour pouvoir réagir de façon adaptée (failles, surconsommation, ..).

AWS - Centralisation de l’authentification

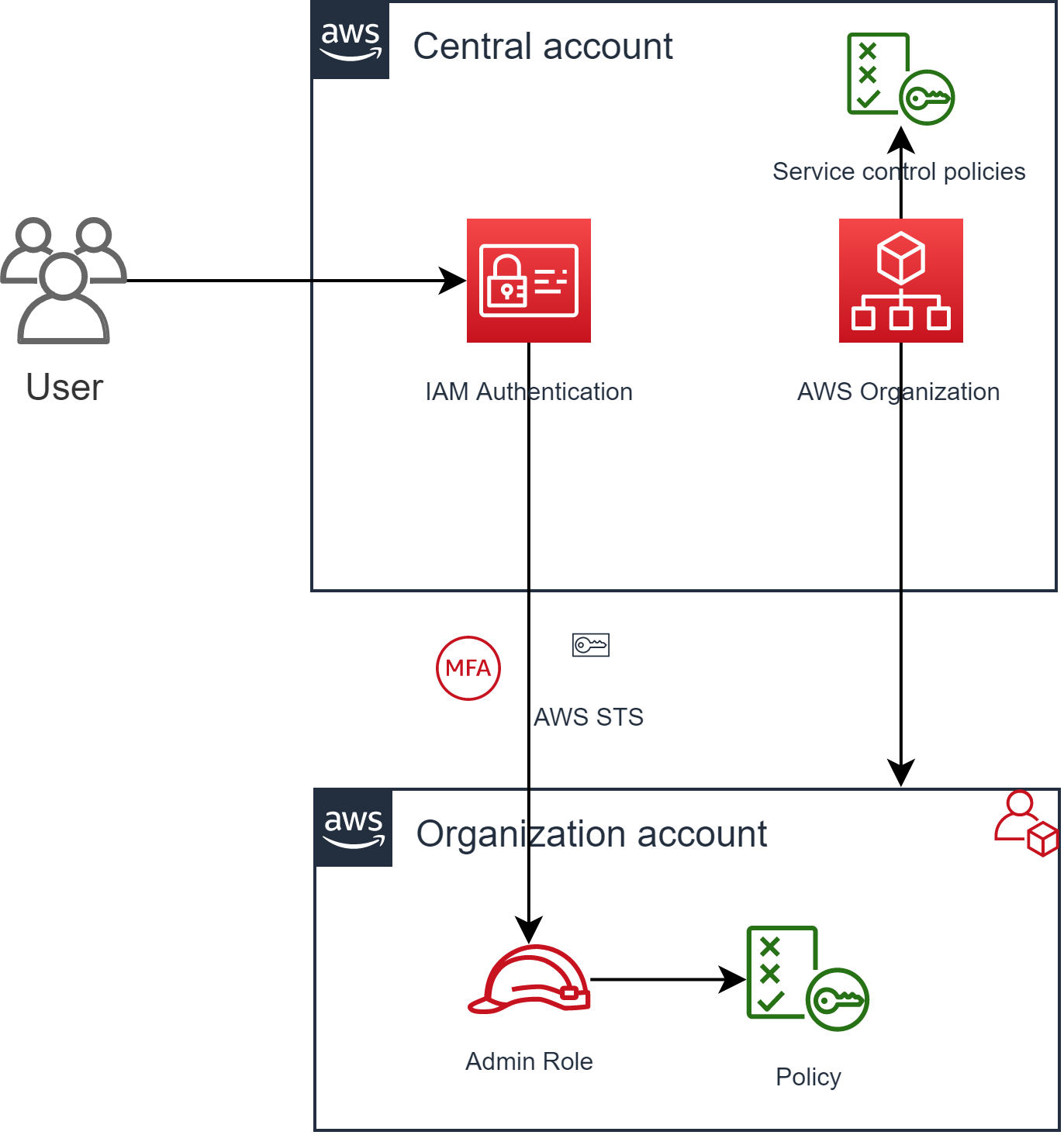

Sur AWS, cela se manifeste notamment par la mise en place d’une landing zone afin de centraliser l’authentification et la gestion des autorisations.

Ainsi, les comptes sont créés et gérés via AWS Organization, qui permet d’appliquer des services control policies sur le compte fils, fixant des limites infranchissables dans ce dernier, ainsi les zones de déploiement sont par exemple limitées, et ce quelle que soit l’autorisation associée au rôle utilisé, selon le même principe que les policies inbound.

Les utilisateurs se connectent donc sur le compte central et rebondissent sur le compte cible via un switch role. Cette méthode permet d’avoir un point d’entrée unique pour se connecter sur AWS, et permet en même temps de simplifier la gestion des autorisations.

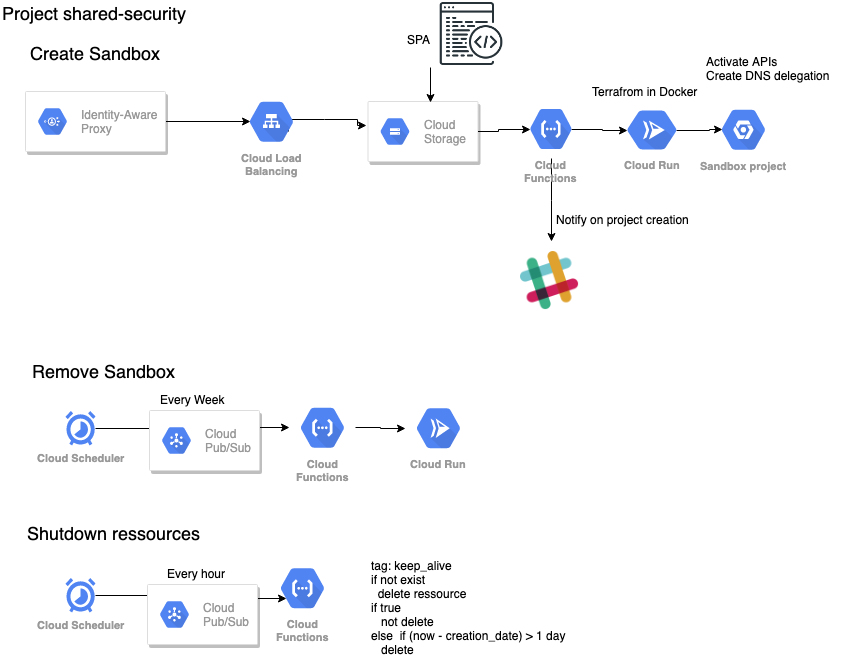

Notre premier besoin au sein de notre infrastructure GCP est de pouvoir disposer de sandbox à la demande qui seront supprimé toutes les semaines et les ressources non tagué toutes les heures via des cloud scheduler tapant sur Pub/Sub afin de déclencher le trigger de la cloud Functions, ce qui nous permettra d’avoir un contrôle sur les ressources créer et sur le coûts globaux.

Lors de cette HandsOn sur la sécurité pour la partie GCP nous avons aussi mise en place :

- L’alerting via pub/sub et cloud function sur un slack et par mail via selon les alertes remonté par Cloud security command center et pour les alertes de billing.

- Des organizations policy afin de définir des quota sur les différentes ressources comme CPU , RAM , etc… ainsi que le blocage de création de ressource avec du GPU.

Présentation avancée de Git pour les Ops

Pour finir cette journée riche, Lilian nous a fait un tour d’horizon de Git.

L’objectif de cette présentation était de faire un rapide tour d'horizon sur le gestionnaires de versions existant actuellement. comprendre quelle ont été les motivation initiales autour de la création de git. nous avons poursuivi avec un tour d'horizon avec le guide de l’usage au quotidien sur git. Pour finir il a été présenté l’implémentation de gitflow, mode de branche ayant pour objectif de répondre aux besoins des cycles de vie des releases applicatives.